Den nylige introduktion af GPT-4 , den mest avancerede version af GPT store sprogmodel skabt af OpenAI, har gjort opmærksom på de væsentlige forskelle mellem denne nye iteration og dens forgænger, GPT-3. GPT-3's fremgang til berømmelse kom i form af den enormt populære avancerede generative tekstchatbot ChatGPT .

Dets imponerende menneskelignende svar og nuancerede forståelse var så revolutionerende, at det er svært at forestille sig en så hurtig forbedring af denne teknologiske bedrift, og alligevel lover GPT-4 endnu større og bedre muligheder. Kampen om GPT3 vs. GPT4 fortsætter med at være konkurrencedygtig, da begge modeller er monumentale bedrifter inden for generativ AI-teknologi.

Prøv selv disse to GPT-versioner

Du kan øjeblikkeligt prøve vores chatboks nedenfor og undersøge GPT-4 vs. GPT-3 for at få en dybere forståelse af, hvordan præcis disse OpenAI-modeller adskiller sig.

Hvad er GPT-3 og GPT-4 ?

GPT, eller Generative Pre-trained Transformers, er neurale netværksmodeller eller maskinlæringsmodeller, der har vist sig at være afgørende for den moderne udvikling af kunstig intelligens. Disse modeller og den forbindelsesteknologi, de er forankret i, er det, der giver værktøjer som ChatGPT deres menneskelignende kontekstforståelse og samtaleevner, hvilket gør dem i stand til at opfange nuancerne i det menneskelige sprog og bruge dem i værktøjets svar til brugerne.

Disse modeller trænes ved hjælp af enorme mængder data, såsom webindhold og bøger, før de frigives til offentligheden. Det er sådan, de bliver lært at opfange kontekst, tone og semantik.

GPT-3 og GPT-4 er den seneste udvikling af denne form for teknologi. Holdet hos OpenAI, forskningslaboratoriet, der er ansvarligt for at skabe disse modeller, har arbejdet på at fremme deres store sprogmodeller (LLM'er), siden den allerførste iteration af GPT blev udgivet i 2018.

Mens GPT-1 var ret rudimentær i sin evne til at svare på spørgsmål og give information, er modellerne nået langt på fem korte år.

GPT-3, en stor forbedring i forhold til sin umiddelbare forgænger, blev udgivet i 2020 og var over ti gange større end GPT-2. Den pralede med imponerende 175 milliarder parametre, som er variabler, som udviklerne finjusterer, når de træner modellen til at forbedre dens ydeevne baseret på ny information.

For at sætte dette tal i perspektiv var Turing Natural Language Generation (NLG)-modellen fra Microsoft, som kun havde 10 milliarder parametre, den mest trænede sprogmodel før udgivelsen af GPT-3.

De mest bemærkelsesværdige opgraderinger, som GPT-3 introducerede sammenlignet med tidligere GPT-modeller, var evnen til at skrive funktionel programmeringskode, levere endnu mere sofistikeret og nuanceret sprog og skabe kunstig intelligens. Dets evne til at skabe menneskelignende svar og forstå kontekst var revolutionerende i AI-sprogværktøjer og var en af hovedårsagerne til, at ChatGPT blev en øjeblikkelig sensation.

Så hvad så med GPT-4 ? I 2023 blev den seneste version i GPT-serien introduceret til offentligheden, GPT-4 . Denne nyere iteration går helt sikkert langt i at perfektionere de eksisterende styrker ved GPT-3 samt løse nogle af dens begrænsninger.

En af de mest imponerende præstationer ved GPT-4 er dens evne til at behandle et billedinput som en tekstprompt og reagere på det i overensstemmelse hermed. Selvom denne model kun er tilgængelig for ChatGPT Plus-brugere, er den tilgængelig gratis ved hjælp af Microsoft Bing Chat.

Hvad er store sprogmodeller (LLM'er)?

I sin mest basale form er en stor sprogmodel (LLM) en prædiktiv tekstalgoritme, der behandler naturlige sproginput og giver det følgende ord i en række af ord baseret på de data, det allerede er blevet præsenteret for. Disse modeller er højtuddannede ved at bruge enorme mængder tekst, såsom bøger, artikler, landingssider, opslag på sociale medier, tekstbeskeder og meget mere.

Modellerne bruger disse materialer til at lære sprogsekvenser og forudsige tekstmønstre, som danner grundlaget for interaktive chatbots som ChatGPT , samt andre AI-værktøjer.

Men denne praksis er ikke let eller billig. Store, kostbare serverfarme, der fungerer som supercomputere, bruges til at indtage disse tekstmaterialer og derefter "beslutte" sig for forudsigelige tekster baseret på de sekvenser, de er stødt på. Desuden skal udviklere være selektive med, hvilket materiale de tilfører LLM.

Hvis materialet er partisk, unøjagtigt eller ufuldstændigt, vil den responsive tekst, der genereres af LLM, være lige så uønsket.

Hvad er OpenAI?

Etableret i 2015 af en gruppe teknologiske ledere i San Francisco, startede OpenAI som en non-profit organisation. Milliardær CEO for SpaceX og Tesla, Elon Musk, er blot et af de fremtrædende navne, der er ansvarlige for virksomhedens oprindelige grundlæggelse, sammen med Peter Thiel, Reid Hoffman, den nuværende CEO for OpenAI Sam Altman og andre.

Organisationens hovedmål var at fremme udviklingen af kunstig generel intelligens, før store teknologivirksomheder som Google eller Apple kunne monopolisere deres potentiale. I navnet på at skabe gennemsigtig, etisk kunstig intelligens, der var bredt tilgængelig for offentligheden, var den lille virksomhed i stand til at vinde betydelige midler fra Silicon Valley-investorer som Infosys og Amazon Web Services.

Det varede ikke længe, før de høje omkostninger ved virksomhedens bestræbelser på at gøre det næsten umuligt at fungere som en almennyttig virksomhed. I 2019 gik det over til at blive en profitvirksomhed, og det var også her, Sam Altman overtog tøjlerne som administrerende direktør. Et partnerskab på 1 milliard dollar med Microsoft sikrede, at noget af OpenAIs teknologi ville blive kommercialiseret og licenseret af teknologigiganten.

OpenAI's capped profit model sikrede dog, at investorer kun kunne tjene 100 gange deres oprindelige investering tilbage, hvilket skabte noget af en hybrid mellem non-profit og for-profit, med den hensigt at prioritere deres "positive human impact"-mission.

I november 2022 blev virksomheden et kendt navn tilsyneladende fra den ene dag til den anden, efter at den udgav sin første chatbot, der frit kunne interageres med, ChatGPT . Værktøjets menneskelignende svar, tilsyneladende uendelige viden og evne til at fremvise kreativitet var ulig noget, verden havde set fra en chatbot før.

Dens popularitet fik også globale teknologivirksomheder til at kapløbe om at frigive deres egne versioner af værktøjet i et forsøg på enten at konkurrere med eller efterligne, hvad ChatGPT har opnået, hvor nogle endda formåede at overgå det, såsom HIX.AI 's HIX Chat .

Siden udgivelsen af GPT-1 i 2018 har organisationen fortsat med at gøre banebrydende fremskridt inden for AI-teknologi og er fortsat en af de største aktører inden for generative AI-værktøjer.

Udviklingshistorie

I februar 2018 udgav OpenAI den allerførste GPT-model, GPT-1. Med 117 millioner parametre var træningsmetoden, der blev brugt til at udvikle denne model, stort set uden opsyn og fokuseret på at lære modellen at forudsige det følgende ord i en sætning, uden nogen specifik opgave foreskrevet.

Selvom den stadig var en tidlig form for generativ AI-tekst, var modellen stadig bemærkelsesværdig for sin tid, fordi den kunne generere forståelige sætninger og endda tekstafsnit fra bunden.

Året efter forbedrede OpenAI sin opfindelse med GPT-2. Denne models 1,5 milliarder parametre skabte et mere sofistikeret og lidt mere avanceret system, der var i stand til at levere længere og mere sammenhængende svar på forespørgsler og prompter. Modellens sproglige evner blev opgraderet, men udover det havde den anden iteration få bemærkelsesværdige resultater.

Både GPT-1 og GPT-2 stod over for begrænsninger med hensyn til deres muligheder og de datasæt, som de blev trænet med. Dette ville ændre sig drastisk med udgivelsen af GPT-3 i 2020.

Med sit massive spring i antallet af parametre sammenlignet med GPT-2 er GPT-3 den første af sin slags til at opnå AI-genereret tekst, der er praktisk talt identisk med menneskers skrivning. Uddannet ved at bruge en monumental mængde skriftligt indhold, har den brudt formen af AI-skrevet tekst og er blevet brugt til at fremme mulighederne for naturlig sprogbehandling (NLP) samt chatbot-funktion.

Disse egenskaber blev yderligere finjusteret og gjort tilgængelige for offentligheden med lanceringen af GPT-3.5 i november 2022. Dette er modellen, som ChatGPT blev skabt på, tog verden med storm og kaster et meget offentligt lys over den hastigt skiftende evner af chatbots og AI-genereret tekst.

GPT-3.5 bragte verdensomspændende opmærksomhed på OpenAIs bestræbelser på at forbedre kunstig generel intelligens og imponerede selv dem i ikke-teknologiske industrier med dets mangfoldige række af output, som omfatter noveller, e-mails, digte, manuskripter, sange, tekstbeskeder, indhold på sociale medier, og meget, meget mere.

Mens både ledere inden for teknologi og dagligdags individer, der interagerede med modellen var enormt imponerede over dens evner, forsikrede Sam Altman masserne om, at GPT-3 og GPT-3.5 stadig kun var tidlige glimt af det sande potentiale og fremtidige resultater af kunstig intelligens og computer sprogindlæring.

Sikkert nok, mindre end seks måneder senere, i marts 2023, blev GPT-4 lanceret. Udviklerne af den nyeste GPT-iteration lover at være mere kreative og samarbejdende end nogensinde før, og de har lagt større vægt på at levere sikrere, mere detaljerede og mere nyttige svar på brugerforespørgsler og tekstprompter.

Større generel viden, på grund af dens overvældende 1,76 billioner parametre og et endnu større datatræningssæt, betyder, at denne model har forbedrede problemløsningsevner og kan give længere tekststykker med en stærkere overordnet kontekst.

At gøre modellerne tilgængelige for offentligheden har også hjulpet OpenAI i dens mission, da begrænsninger og svage punkter på hver model bliver tydelige meget hurtigt gennem massebrug og løbende test på tværs af brancher.

Hvad adskiller OpenAI's GPT-3 og GPT-4 ?

Først og fremmest taler tallene for sig selv. Det faktum, at den nye og forbedrede GPT-4 fungerer på over 100 billioner parametre, sammenlignet med GPT-3's 175 milliarder, siger alt, hvad du behøver at vide om dens forbedrede sprogindlæring, hastighed og overordnede ydeevne.

Token-grænsen, eller antallet af tokens, en LLM kan behandle i en enkelt interaktion, er også blevet væsentligt forbedret mellem GPT-3 vs. 4. GPT-4 -token-grænsen er steget til 32.000, hvilket betyder, at den kan rumme input, der er fire gange længere end for GPT-3.

GPT-4 blev trænet ved hjælp af et væsentligt større datasæt, hvilket udsatte modellen for bredere sammenhænge og endnu mere nuanceret tone og sprog, som den kunne lære og tilpasse sine svar fra. På grund af disse faktorer kan GPT-4 levere mere nøjagtige økonomiske prognoser, udarbejde mere indflydelsesrige investeringsstrategier og overveje forbedret faktuel nøjagtighed.

Faktisk ydeevne i sig selv er en enorm forbedring, der gør GPT-4 til et kæmpe spring fremad for alle dets brugere, da det betyder, at indholdet, der genereres af denne model, er mere pålideligt og mindre tilbøjeligt til at lave dyre fejl.

Når det kommer til skrivning, har GPT-4 vist sig at give brugerne mere kontrol over tonen, leveringen, stilen og stemmen i den tekst, der genereres. GPT-3 kunne til sammenligning kun ændre typen af tekst, der blev genereret med betydelig omskoling. Som et eksempel kan virksomheder nu bruge GPT-4 til at style professionelle e-mails i en anden tone end tongue-in-cheek reklamebeskeder eller engagerende sociale medier billedtekster.

Beskeder kan også skræddersyes til målgrupper i forskellige aldre, købsadfærd og geografiske placeringer, fordi den nyere model kan overveje disse kontekstuelle spor og tilpasse sproget i overensstemmelse hermed.

Højere sprogfærdigheder og kritisk tænkning er også væsentligt mere fremtrædende i GPT-4 , hvilket gør det muligt at løse komplicerede mærkeproblemer, udføre risikovurderinger og hjælpe med kreativ idégenerering. Faktisk scorede GPT-4 imponerende høje resultater på flere professionelle og akademiske eksamener, såsom Uniform Bar Exam, LSAT, GRE, AP Exams, AMC Exams og endda Sommelier Exams.

Et andet aspekt, hvor GPT-4 overgår sin ældste, er flersprogethed. På 24 ud af 26 afprøvede sprog klarede GPT-4 sig bedre end både GPT-3.5 og andre moderne LLM'er baseret på MMLU (Massive Multitask Language Understanding) benchmark. En af de mest opsigtsvækkende opgraderinger introduceret med GPT-4 er imidlertid dens evne til at behandle billedinput som tekstmeddelelser.

Det er rigtigt - brugere kan nu indtaste tekst såvel som billeder for at specificere en opgave, der enten relaterer sig til visuelle eller sproglige, hvilket i høj grad vil hjælpe virksomheder og fagfolk, der primært arbejder med grafik eller multimedieindhold.

Der er også forskel på prisniveauerne på de to modeller. Mens GPT-3 i det væsentlige er gratis at bruge via OpenAI Playground, hvor brugere kan eksperimentere med 12 forskellige varianter af modellen, har GPT-4 en økonomisk omkostning. Prisplaner starter ved $0,03 for 1000 prompt-tokens, eller du kan få adgang til chatbot-varianten af modellen med ChatGPT Plus for $20 pr. måned.

Hvordan kan brugere drage fordel af den avancerede GPT-4 ?

GPT-4 lover at være en katalysator for store ændringer på tværs af flere brancher, der påvirker virksomheder, freelancere, fagfolk og studerende på en lang række værdifulde måder. Nedenfor er blot nogle af de metoder, hvorpå den nyeste GPT-sprogmodel kan hjælpe med at forbedre forretningspraksis og øge produktiviteten og effektiviteten.

Virksomheder, der ønsker at beskytte deres data, aktiver og medarbejdere mod cyberangreb, kan bruge GPT-4 til at overvåge operationer, spore adgang til følsomme oplysninger, analysere og rapportere om mønstre og reagere på potentielle cybersikkerhedstrusler. Dette vil øge forbrugernes tillid til organisationer, især dem, der beskæftiger sig med værdifulde personlige data, såsom banker og private sikkerhedsfirmaer.

Sådanne organisationer kan også bruge denne avancerede model til at opdage svigagtig aktivitet tidligt, hvilket sparer betydelig tid, penge og ressourcer ved at komme sig over sådanne hændelser, efter at de har fundet sted. Uregelmæssig køberadfærd og usædvanlig kontoadgang er blot nogle af de aktiviteter, som GPT-4 kan opfange og bruge til at advare det relevante personale om potentielt bedrageri.

GPT-4 kan bruges af salgsafdelinger til at forudsige efterspørgsel og udbud for bestemte produkter og tjenester ved at spore oplysninger om køberadfærd og tidligere salgsdata. Dette kan hjælpe virksomheder til bedre at administrere deres beholdning, planlægge deres prismodeller, annoncere effektivt og allokere penge og ressourcer.

GPT-4 lover at ændre ansigtet på moderne uddannelse på alle niveauer ved at tilbyde skræddersyede læringsoplevelser, der kan skræddersyes til individuelle elever. Ved at bruge data som elevkarakterer, tilstedeværelsesregistreringer og tekniktilbøjelighed kan GPT-4 tilpasse lektionsplaner, så de passer til individuelle behov og evner for at skabe en mere engagerende og personlig læringsoplevelse for elever i alle aldre.

Mens virtuelle cookies og datasporing i øjeblikket hjælper med at forbedre den virtuelle shoppingoplevelse, kan GPT-4 fremme disse bestræbelser ved at overveje tidligere køb, webbrowserhistorik, personlige præferencer og mere for individuelt at skræddersy online shoppingoplevelsen i endnu højere grad. Dette øger ikke kun salg og brandloyalitet for detailhandlere, men forbedrer også den overordnede indkøbsoplevelse og skaber større lethed og bekvemmelighed for forbrugerne.

Inden for sundhedssektoren har GPT-4 opnået noget, ingen anden GPT-model kan prale af: ved at analysere sygehistorier og bruge klinisk billeddiagnostik, har den været i stand til med succes at foreslå relevante diagnoser for patienter, der oplever sundhedsproblemer, samt anbefale passende behandlingsforløb . Dette kan i høj grad hjælpe læger med at yde den nødvendige pleje, især i lavindkomstområder, hvor faciliteterne er underbemandede.

I industrier som f.eks. fremstilling og logistik kan GPT-4 hjælpe med at forudsige, hvornår vedligeholdelse på udstyr vil være påkrævet i fremtiden ved hjælp af sensordata. Dette kan hjælpe disse virksomheder med at forhindre dyr nedetid og dyre reparationer ved at tage fat på funktionelle problemer tidligt, hvilket yderligere gør dem i stand til at øge produktiviteten og operere mere effektivt.

Markedsførere, administratorer af sociale medier og indholdsskabere kan udnytte potentialet i GPT-4 ved at bruge både dets viden og dets sproglige evner til at udforme effektive marketingstrategier, udtrykke værdiforslag, skrive billedtekster til sociale medier og udvikle artikler og blogindlæg i lang form. der lyder naturligt og menneskeligt i deres læsbarhed.

Områderne journalistik, underholdning og kunst kan også være væsentligt påvirket af funktionerne og kapaciteterne i GPT-4 . At generere nye ideer, give alternative perspektiver og analysere tidligere praksis er alle måder, hvorpå denne nyere GPT-model kan hjælpe med at forbedre sådanne levebrød uden at gøre dem overflødige helt.

Mens GPT-3 og GPT-3.5 også kunne hjælpe brugere på nogle af de ovennævnte måder, er dens funktioner blevet væsentligt forbedret og finjusteret i den seneste model. Opgraderinger i ydeevne, sprogindlæring, datasporing, kontekstovervejelse og faktuel nøjagtighed har gjort modellens overordnede anvendelighed mere tilgængelig og relevant for en bredere vifte af professioner og forretningsfunktioner.

Begrænsninger for GPT-3 vs. GPT-4

Mens deres lister over evner er lange og imponerende, er GPT-3 og endda GPT-4 stadig begrænset af visse teknologiske begrænsninger. For eksempel er menneskeskabte barrierer beregnet til at forhindre misbrug og skabelse af stødende indhold nyttige og nødvendige, men de kan hindre GPT's evne til at besvare gyldige spørgsmål.

Dette er et problem, der er relevant for begge modeller. Ingen af modellerne har evnen til at levere information i realtid – noget andre AI-genererede tekstværktøjer har været i stand til at opnå.

Hvis vi ser på flersprogethed i GPT 3.5 vs. GPT 4, er begge modeller stadig begrænsede med hensyn til de tjenester, de kan levere på andre sprog end engelsk. Både oversættelsesnøjagtigheden og mangfoldigheden af sprog, der tages hensyn til, kan betragtes som begrænsninger i denne henseende, og dette er fortsat en hindring for begge modeller.

Selvom GPT-4 har introduceret den bemærkelsesværdige evne til at overveje billedinput, kan den stadig ikke betragte lyd eller video som prompter. Forhåbentlig er dette en funktion, som udviklere kan overveje i forbindelse med skabelsen af GPT-5, men vi kan endnu ikke være sikre.

Alternative værktøjer, der bruger GPT-modellerne

Du ville blive tilgivet for at antage, at ChatGPT er den mest effektive og effektive brug af GPT-modellerne. I virkeligheden bør værktøjer skabt af andre teknologiske konkurrenter, der bruger den samme teknologi, på ingen måde undervurderes. Det kan nemt argumenteres for, at nogle af dem matcher og endda overgår mulighederne i ChatGPT , som har sin rimelige andel af begrænsninger og forhindringer.

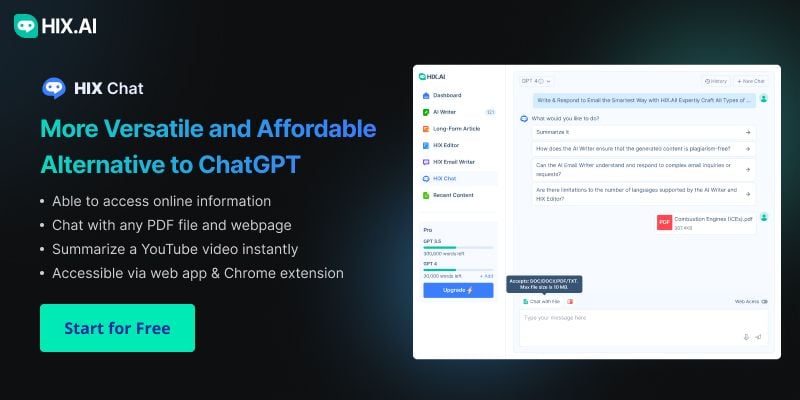

En bemærkelsesværdig konkurrent er HIX.AI 's HIX Chat , et værktøj, der understøtter både GPT-3.5 og GPT-4 . Denne alt-i-en chatbot har til formål at forbedre kommunikationen, give præcise og menneskelignende svar på enhver forespørgsel og opbygge engagerende samtaler med brugere. I modsætning til ChatGPT og mange andre samtidige, har den direkte internetadgang, så den kan levere ajourførte oplysninger i realtid uden forsinkelser eller begrænsninger.

Imponerende nok går det ud over evnerne til ChatGPT ved at læse PDF'er og besvare spørgsmål baseret på indholdet, opsummere YouTube videoer, når der er et link, og opbygge kontekstuel samtale baseret på websideindhold. Den er tilgængelig via en webapp samt en browserudvidelse, der kan anvendes til både Google Chrome og Microsoft Edge .

Selvom ingen anden chatbot kan prale af ovenstående funktioner, er YouChat, Microsoft Bing Chat og Perplexity Ask blot nogle få af de mest dygtige chatbotværktøjer, der enten matcher eller overgår mulighederne i ChatGPT ved hjælp af enten GPT-3 eller GPT-4 .

Fremtidige udviklinger af GPT

Mens OpenAI i øjeblikket dedikerer de fleste af sine ressourcer til at udvikle den meget ventede GPT-5-model, er denne skabelse stadig i sine meget tidlige stadier og trænes endnu ikke aktivt. Da træning, forsøg og sikkerhedsforanstaltninger alle skal implementeres, før den lanceres til offentligheden, kan vi forvente at vente et stykke tid, før denne model ser dagens lys.

Inkorporeringen af video- og lydfunktioner som funktionelt input ville kræve brug af både webkodning og videomedier som træningsmateriale til fremtidige GPT-modeller, hvilket Altman har hentydet til, da han blev spurgt om, hvad vi kan forvente af fremtidige versioner. Evnen til at fortolke andre input uden for den skrevne tekst ville være et bemærkelsesværdigt gennembrud for LLM'er, der i høj grad udvider omfanget af, hvad de kan levere og opnå.

Ud over denne forudsigelse kan der ikke forudses meget andet med hensyn til, hvad fremtidige modeller kan udrette. Da kunstig generel intelligens stadig er et stort set eksperimentelt felt, er nye potentielle og uventede muligheder kendt for at dukke op tilsyneladende ud af ingenting, så der er simpelthen ikke noget at sige til, hvad disse avancerede enheder kan være i stand til at lære og tilpasse sig i fremtiden.

Sammenfattende

Man kan uomtvisteligt sige, at både GPT-3 og GPT-4 LLM'erne har ændret landskabet for kunstig generel intelligens, som vi kender det, og sikret, at AI-værktøjer bliver et certificeret aspekt af fremtidens samfund.

Fremme af disse modeller har banet vejen for holistiske, banebrydende AI-platforme såsom HIX.AI , en kraftfuld 'one-stop-shop', der tilbyder en række forskellige AI-skriveløsninger, der imødekommer utallige forbrugerbehov, alle understøttet og forbedret af GPT-3.5 og GPT-4 .

Det kan være let at undervurdere, hvor markante forskellene kan være, i betragtning af at de to modeller blev udgivet med mindre end tre års mellemrum, men dette er udelukkende et vidnesbyrd om, hvor meget OpenAI og HIX.AI har opnået på så kort tid. Vi kan kun håbe, at GPT-5 og fremtidige modeller vil fortsætte med at bane vejen for standarden for AI-værktøjer og transformere den måde, vi lever, arbejder, skaber og samarbejder på.