Skriv // for at nyde vores AI-hjælp, mens du skriver på Google Docs.

Skriv // lav overbevisende e-mails og personlige svar.

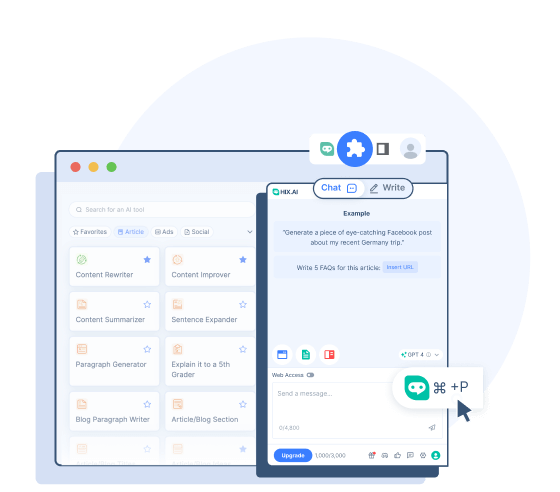

Udforsk et mere kraftfuldt Bing sidebar-alternativ til Chrome.

Find HIX.AI's omfattende svar blandt typiske søgeresultater.

Vælg enhver tekst online for at oversætte, omskrive, opsummere osv.

Skriv // for at komponere kortfattet, men alligevel kraftfuldt Twitter-indlæg om den tendens.

Skriv // for at oprette engagerende billedtekster til dine Instagram-opslag.

Skriv // for at lave et udkast til interaktive Facebook-indlæg, der engagerer dit fællesskab.

Skriv // for at give værdifulde, opstemte svar på Quora.

Skriv // for at lave Reddit-indlæg, der giver genklang med specifikke fællesskaber.

Opsummer lange YouTube-videoer med et enkelt klik.

- HIX Chat (ChatGPT Alternativ)

En førende AI-chatbot, der kan svare med opdaterede oplysninger.

- HIX Chat (Intet login)

Oplev ubegrænset adgang til HIX Chat. Ingen login er nødvendig.

- GPT-4o (ingen login)

Prøv den avancerede kraft fra GPT-4o med færre begrænsninger og jævnere forbindelse.

- ChatGPT (ingen login)

Brug ChatGPT gratis uden at logge ind!

- GPT-4 Chat online

Brug GPT-4 chatbot gratis online.

- Math AI Solver

Få trin-for-trin-løsninger til ethvert matematisk lektieproblem.

GPT-4o

- Historie

GPT-4o: Den næste udvikling af OpenAI's sprogmodeller

GPT-4o ("o" betyder "omni") er en avanceret multimodal storsprogsmodel udviklet af OpenAI og udgivet den 13. maj 2024. Den bygger på succesen med GPT-familien af modeller og introducerer flere fremskridt med hensyn til omfattende forståelse og generering af indhold på tværs af forskellige modaliteter.

GPT-4o tilbyder bedre naturlige sprogbehandlingsmuligheder og en hurtigere responstid sammenlignet med tidligere modeller. Det kan indbygget forstå og generere tekst, billeder og lyd, hvilket muliggør mere intuitive og interaktive brugeroplevelser. Dette gør det muligt for GPT-4o at have forbedrede evner til ikke kun at besvare vidensbaserede spørgsmål og skabe tekst, men også analysere og beskrive billeder og videoer.

GPT-4o's muligheder

De nye forbedringer, som OpenAI bringer til denne model, løfter dens lyd-, vision- og tekstegenskaber.

Multimodal input og output

Hvert input og output af GPT4-o kan være enhver kombination af tekst, lyd og billeder. I modsætning til OpenAIs tidligere modeller behandles al tekst, lyd og billeder uden nogen form for konvertering (GPT-4o kan læse billeder, høre lyd og sende dem direkte). Dette giver GPT-4o mulighed for at behandle dem hurtigere og få en bedre forståelse af disse elementer.

Naturlige samtaler i realtid

GPT-4o's forbedrede stemmegenkendelse og responsfunktioner gør det muligt for dem at deltage i verbale samtaler (selv på forskellige sprog) uden mærkbare forsinkelser. Modellen kan observere toner og følelser hos højttalerne og levere korrekte svar. Den kan også tale med en naturlig stemme og med følelsesmæssige nuancer, hvilket muliggør mere følsom kommunikation.

Visuel indholdsanalyse og redigering

GPT-4o kan bedre forstå og redigere visuelt indhold. Den kan læse grafik, tekst eller data på billeder og forstå betydningen bag. Du kan uploade billeder til analyse og få mere præcise indsigter og forklaringer. Modellen kan også oprette eller redigere billeder lige så præcist som dine anmodninger med høj kvalitet.

Hukommelse og kontekstuel bevidsthed

GPT-4s opgraderede kontekstvindue sikrer, at den kan bevare konteksten over længere samtaler. Den understøtter op til 128.000 tokens, hvilket muliggør detaljerede analyser og sammenhængende samtaler.

GPT-4o vs GPT-4 vs GPT-3.5

Vil du vide, hvordan GPT-4o er forskellig fra GPT-4 og GPT-3.5? Her er deres vigtigste forskelle:

GPT-4o

- GPT-4o blev oprindeligt udgivet i maj 2024.

- Det er en mere avanceret multimodal model med hurtigere hastigheder og lavere forsinkelser til at reagere på lyd- og videoinput.

- GPT-4o er trænet på data op til oktober 2023.

- GPT-4o klarer sig bedre på benchmarks for ræsonnement, talegenkendelse og visuelle muligheder.

- Det har en betydelig forbedring af tekstbehandling på ikke-engelske sprog.

GPT-4

- GPT-4 blev oprindeligt udgivet i marts 2023.

- Det er en multimodal model, hvilket betyder, at den kan forstå billed- og stemmeinput sammen med tekstprompter.

- GPT-4 er trænet i mere opdaterede data frem til december 2023.

- GPT-4 klarer sig bedre end GPT-3.5 på områder som kodning, skrivning, ræsonnement og undgåelse af forbudt indhold.

- GPT-4 er mere pålidelig og kreativ og har bedre resultater på benchmarks end GPT-3.5.

GPT-3.5

- GPT-3.5 blev udgivet i november 2022. Den driver den gratis version af ChatGPT.

- GPT-3.5 er begrænset til tekstinput og -output.

- Den er trænet på ældre data frem til september 2021.

- GPT-3.5 kan nogle gange være mindre pålidelig og kreativ, når den genererer svar.

Sådan får du adgang til GPT-4o

GPT-4o er blevet gjort tilgængelig siden udgivelsen. Der er flere måder, du kan få adgang til og opleve dens kraft på:

Brug GPT-4o på ChatGPT

OpenAI har givet ChatGPT-brugere mulighed for at bruge denne nye model direkte på chatbotten. Gratis brugere vil have adgang med beskedbegrænsning og kan kun interagere med denne model med tekst. For de betalte ChatGPT Plus-brugere er alle disse begrænsninger ophævet.

Brug GPT-4o med OpenAI's API

OpenAI har også gjort GPT-4o tilgængelig som en modelmulighed for API-adgang. Udviklere har nu lov til at integrere GPT-4o-kraften i deres projekt eller applikation.

Brug GPT-4o på HIX.AI

Hvis du har brug for en mere bekvem måde at få adgang til GPT-4o, kan du prøve det på HIX.AI. Det er gratis at prøve uden at skulle logge ind. Hvis du er begrænset fra at få adgang til GPT-4o gennem de officielle metoder, er dette en anden pålidelig måde at bruge denne innovative model på.

Hvorfor bruge GPT-4o på HIX.AI

Adgang til GPT-4o på HIX.AI kommer med flere fordele:

Intet login påkrævet

Oplev bekvemmeligheden ved øjeblikkelig adgang med HIX.AI. Bare naviger til vores GPT-4o-side, og du kan begynde at interagere med GPT-4o med det samme.

Glattere forbindelse

Når du tilgår GPT-4o på HIX.AI, er det mindre sandsynligt, at du oplever serverproblemer. Vi bestræber os på at minimere latens og opretholde høj ydeevne for din forbindelse til denne model.

Ubegrænset adgang

Vi pålægger ingen begrænsninger på vores GPT-4o chatbot-adgang. Uanset hvor og når du er, kan du frit opleve denne kraftfulde AI-innovation.

Oplev flere ressourcer om GPT-4 og ChatGPT

Lær mere om de mest avancerede sprogmodeller med vores informative artikler her:

ChatGPT websted: Ting du behøver at vide om det officielle websted

Hvad er de vigtigste fakta, du bør vide om ChatGPT webstedet? Læs videre for en hurtig introduktion til ChatGPT siden.

Er ChatGPT nede lige nu?

Hvis du har problemer med at bruge ChatGPT , spekulerer du sikkert på: "Er ChatGPT nede lige nu?" Vi fortæller dig, hvis der er en ChatGPT udfald, og forklarer serverstatus lige her.

Sådan omgår ChatGPT filter

Oplev fire effektive metoder til at omgå ChatGPT filtre. Udforsk HIX Chat , et pålideligt og avanceret alternativ til ChatGPT uden begrænsninger.

Hvordan tjener man penge på ChatGPT ? 5 effektive strategier!

I denne artikel vil vi udforske fem enkle, men yderst effektive strategier til at udnytte ChatGPT magt og låse op for nye indtægtsstrømme gennem affiliate marketing og annoncering.

10 bedste AI-chatbots online

Leder du efter den bedste AI chatbot online? Vil du finde et ChatGPT alternativ? Lær mere om, hvad der er tilgængeligt, og find den rigtige AI-chatbot fra denne omfattende liste.

Plagierer ChatGPT ?

Plagierer ChatGPT ? Vi vil diskutere alle relevante oplysninger og besvare det almindelige spørgsmål; er ChatGPT plagiat?

Ofte stillede spørgsmål

Hvordan overgår GPT-4o de tidligere modeller?

De største fordele ved GPT-4o i forhold til de tidligere modeller er dens forbedrede multimodale muligheder, som gør den i stand til at udføre samtaler i realtid og avanceret vision/lydhåndtering med lavere latenser.

Kan GPT-4o hjælpe mig med at oversætte sprog?

Ja. GPT-4o kommer med bedre flersprogede muligheder og kan fungere som en god oversætter til 50+ sprog.

Hvad er skæringsdatoen for viden for GPT-4o?

Sidste dato for viden, eller den seneste information, GPT-4o blev trænet på, er oktober 2023.

Har GPT-4o nogen begrænsninger?

På trods af sine muligheder har GPT-4o stadig begrænsninger, der er nedarvet fra store sprogmodeller som potentielle skævheder, hallucinationer og mangel på robust langtidshukommelse. Dens viden er også grundlæggende begrænset til dens træningsdata.