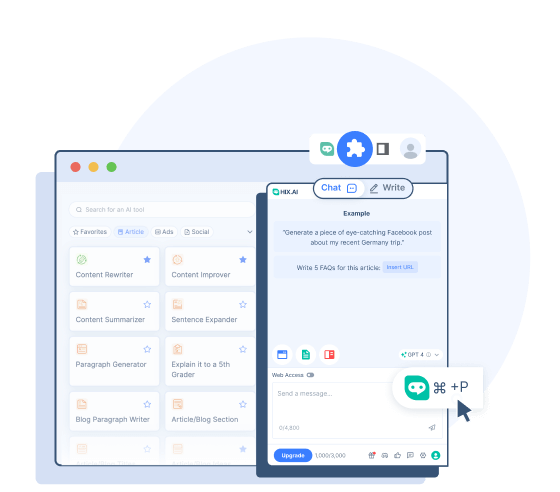

HIX Writer

Erhalten Sie Zugriff auf über 120 KI-Schreibtools, um Ihr Schreiberlebnis zu verbessern.

Überprüfen Sie HIX Writer

BrowserGPT

Entdecken Sie den leistungsstärksten All-in-One-ChatGPT-Assistenten für das Web.

Überprüfen Sie BrowserGPT

Geben Sie // ein, um unsere KI-Unterstützung beim Schreiben in Google Docs zu nutzen.

Schreiben Sie // überzeugende E-Mails und personalisierte Antworten.

Entdecken Sie eine leistungsstärkere Bing-Sidebar-Alternative für Chrome.

Finden Sie die umfassenden Antworten von HIX.AI in typischen Suchergebnissen.

Wählen Sie online einen beliebigen Text zum Übersetzen, Umschreiben, Zusammenfassen usw. aus.

Geben Sie // ein, um prägnante, aber aussagekräftige Twitter-Beiträge zu diesem Trend zu verfassen.

Geben Sie // ein, um ansprechende Untertitel für Ihre Instagram-Beiträge zu erstellen.

Geben Sie // ein, um interaktive Facebook-Beiträge zu entwerfen, die Ihre Community einbeziehen.

Geben Sie // ein, um wertvolle, positiv bewertete Antworten auf Quora bereitzustellen.

Geben Sie // ein, um Reddit-Beiträge zu erstellen, die bei bestimmten Communities Anklang finden.

Fassen Sie lange YouTube-Videos mit einem Klick zusammen.

- HIX Chat (ChatGPT-Alternative)

Ein führender KI-Chatbot, der mit aktuellen Informationen antworten kann.

- HIX Chat (Kein Login)

Erleben Sie uneingeschränkten Zugang zu HIX Chat. Es ist keine Anmeldung erforderlich.

- GPT-4o (Keine Anmeldung)

Testen Sie die erweiterte Leistung von GPT-4o mit weniger Einschränkungen und reibungsloserer Verbindung.

- ChatGPT (Kein Login)

Nutzen Sie ChatGPT kostenlos, ohne sich anzumelden!

- GPT-4-Chat online

Nutzen Sie den GPT-4-Chatbot kostenlos online.

- Mathe-KI-Löser

Erhalten Sie Schritt-für-Schritt-Lösungen für alle Mathe-Hausaufgaben.

GPT-4o

- Geschichte

GPT-4o: Die nächste Evolutionsstufe der Sprachmodelle von OpenAI

GPT-4o (das „o“ steht für „omni“) ist ein hochmodernes multimodales Großsprachenmodell, das von OpenAI entwickelt und am 13. Mai 2024 veröffentlicht wurde. Es baut auf dem Erfolg der GPT-Modellfamilie auf und führt mehrere Fortschritte beim umfassenden Verständnis und der Generierung von Inhalten über verschiedene Modalitäten hinweg ein.

GPT-4o bietet im Vergleich zu früheren Modellen bessere Funktionen zur Verarbeitung natürlicher Sprache und eine schnellere Reaktionszeit. Es kann Text, Bilder und Audio nativ verstehen und generieren und ermöglicht so intuitivere und interaktivere Benutzererlebnisse. Dadurch verfügt GPT-4o über verbesserte Fähigkeiten, nicht nur wissensbasierte Fragen zu beantworten und Texte zu erstellen, sondern auch Bilder und Videos zu analysieren und zu beschreiben.

Funktionen von GPT-4o

Die neuen Verbesserungen, die OpenAI diesem Modell bietet, steigern dessen Audio-, Bild- und Textfunktionen.

Multimodale Eingabe und Ausgabe

Jeder Input und Output von GPT4-o kann eine beliebige Kombination aus Text, Audio und Bildern sein. Anders als bei den Vorgängermodellen von OpenAI werden alle Texte, Audiodaten und Bilder ohne jegliche Konvertierung verarbeitet (GPT-4o kann Bilder lesen, Audiodaten hören und direkt ausgeben). Dies bietet GPT-4o die Möglichkeit, sie schneller zu verarbeiten und diese Elemente besser zu verstehen.

Natürliche Gespräche in Echtzeit

Die verbesserten Spracherkennungs- und Antwortfunktionen von GPT-4o ermöglichen es ihm, ohne merkliche Verzögerungen an verbalen Gesprächen (auch in verschiedenen Sprachen) teilzunehmen. Das Modell kann Tonfall und Emotionen der Sprecher beobachten und entsprechende Antworten geben. Es kann auch mit natürlicher Stimme und emotionalen Nuancen sprechen, was eine sensiblere Kommunikation ermöglicht.

Visuelle Inhaltsanalyse und Bearbeitung

GPT-4o kann visuelle Inhalte besser verstehen und bearbeiten. Es kann Grafiken, Texte oder Daten auf Bildern lesen und die Bedeutung dahinter verstehen. Sie können Bilder zur Analyse hochladen und so genauere Einblicke und Erklärungen erhalten. Das Modell kann Bilder auch genau nach Ihren Eingabeanforderungen und in hoher Qualität erstellen oder bearbeiten.

Gedächtnis und Kontextbewusstsein

Das verbesserte Kontextfenster von GPT-4 stellt sicher, dass der Kontext auch bei längeren Konversationen erhalten bleibt. Es unterstützt bis zu 128.000 Token und ermöglicht so detaillierte Analysen und zusammenhängende Konversationen.

GPT-4o vs. GPT-4 vs. GPT-3.5

Möchten Sie wissen, wie sich GPT-4o von GPT-4 und GPT-3.5 unterscheidet? Hier sind die wichtigsten Unterschiede:

GPT-4o

- GPT-4o wurde ursprünglich im Mai 2024 veröffentlicht.

- Es handelt sich um ein fortschrittlicheres multimodales Modell mit höheren Geschwindigkeiten und geringeren Latenzen bei der Reaktion auf Audio- und Videoeingaben.

- GPT-4o wird anhand von Daten bis Oktober 2023 trainiert.

- GPT-4o schneidet bei Benchmarks in den Bereichen logisches Denken, Spracherkennung und visuelle Fähigkeiten besser ab.

- Es bietet erhebliche Verbesserungen bei der Textverarbeitung in anderen Sprachen als Englisch.

GPT-4

- GPT-4 wurde ursprünglich im März 2023 veröffentlicht.

- Es handelt sich um ein multimodales Modell, das heißt, es kann neben Textaufforderungen auch Bild- und Spracheingaben verstehen.

- GPT-4 wird bis Dezember 2023 anhand aktuellerer Daten trainiert.

- In Bereichen wie Codierung, Schreiben, Argumentieren und Vermeiden unzulässiger Inhalte bietet GPT-4 bessere Leistungen als GPT-3.5.

- GPT-4 ist zuverlässiger und kreativer und schneidet bei Benchmarks besser ab als GPT-3.5.

GPT-3.5

- GPT-3.5 wurde im November 2022 veröffentlicht. Es basiert auf der kostenlosen Version von ChatGPT.

- GPT-3.5 ist auf Texteingabe und -ausgabe beschränkt.

- Es wird anhand älterer Daten bis September 2021 trainiert.

- GPT-3.5 kann beim Generieren von Antworten manchmal weniger zuverlässig und kreativ sein.

So greifen Sie auf GPT-4o zu

GPT-4o ist seit seiner Veröffentlichung zugänglich gemacht. Es gibt mehrere Möglichkeiten, wie Sie auf seine Leistung zugreifen und sie erleben können:

Verwenden Sie GPT-4o auf ChatGPT

OpenAI hat es den ChatGPT-Benutzern ermöglicht, dieses neue Modell direkt im Chatbot zu verwenden. Kostenlose Benutzer haben Zugriff mit Nachrichtenbeschränkung und können nur per Text mit diesem Modell interagieren. Für die kostenpflichtigen ChatGPT Plus-Benutzer sind alle diese Beschränkungen aufgehoben.

Verwenden Sie GPT-4o mit der API von OpenAI

OpenAI hat GPT-4o auch als Modelloption für den API-Zugriff verfügbar gemacht. Entwickler können nun die Leistung von GPT-4o in ihr Projekt oder ihre Anwendung integrieren.

Verwenden Sie GPT-4o auf HIX.AI

Wenn Sie einen bequemeren Weg zum Zugriff auf GPT-4o benötigen, können Sie es auf HIX.AI ausprobieren. Sie können es kostenlos ausprobieren, ohne sich anmelden zu müssen. Wenn Sie nicht über die offiziellen Methoden auf GPT-4o zugreifen können, ist dies eine weitere zuverlässige Möglichkeit, dieses innovative Modell zu verwenden.

Warum GPT-4o auf HIX.AI verwenden?

Der Zugriff auf GPT-4o auf HIX.AI bietet mehrere Vorteile:

Keine Anmeldung erforderlich

Erleben Sie den Komfort des sofortigen Zugriffs mit HIX.AI. Navigieren Sie einfach zu unserer GPT-4o-Seite und Sie können sofort mit der Interaktion mit GPT-4o beginnen.

Reibungslosere Verbindung

Beim Zugriff auf GPT-4o auf HIX.AI treten seltener Serverprobleme auf. Wir bemühen uns, die Latenz zu minimieren und eine hohe Leistung für Ihre Verbindung zu diesem Modell aufrechtzuerhalten.

Unbeschränkter Zugang

Wir legen keine Einschränkungen für den Zugriff auf unseren GPT-4o-Chatbot fest. Wo und wann immer Sie sind, können Sie diese leistungsstarke KI-Innovation frei erleben.

Entdecken Sie weitere Ressourcen zu GPT-4 und ChatGPT

Erfahren Sie mehr über die fortschrittlichsten Sprachmodelle in unseren informativen Artikeln hier:

Eine vollständige Anleitung zur Sprachsteuerung für Chat GPT

Die Sprachsteuerung für ChatGPT macht die Kommunikation mit dem KI-Chatbot einfacher als je zuvor. So funktioniert die Sprachsteuerung für Chat GPT.

Ist ChatGPT gerade nicht verfügbar?

Wenn Sie Probleme bei der Verwendung ChatGPT haben, fragen Sie sich wahrscheinlich: „Ist ChatGPT gerade nicht verfügbar?“ Wir informieren Sie hier über einen ChatGPT Ausfall und erläutern den Serverstatus.

Die 40 besten ChatGPT -Beispiele

Entdecken Sie diese transformativen Einsatzmöglichkeiten von ChatGPT in den Bereichen Codierung, Jobsuche, Marketing, Inhaltserstellung und mehr. Schauen Sie sich diese Seite an, um zu sehen, wie HIX.AI eine fortschrittliche, kostengünstige Alternative zu ChatGPT bietet!

Können Lehrer ChatGPT erkennen?

Finden Sie heraus, ob Lehrer die Verwendung von ChatGPT erkennen können, und erkunden Sie Alternativen wie HIX.AI , die einer Erkennung entgehen können.

Wie verwende ich ChatGPT in Saudi-Arabien?

Erfahren Sie, wie Sie ChatGPT in Saudi-Arabien verwenden und wie Sie Websites in Saudi-Arabien mit HIX Chat entsperren.

Wie kann man mit Chat GPT Geld verdienen?

Haben Sie schon einmal darüber nachgedacht, wie Sie mit Chat GPT Geld verdienen können? Wir haben einen umfassenden Leitfaden zusammengestellt, wie Sie mit Chat GPT Geld verdienen können.

FAQs

Inwiefern übertrifft GPT-4o die Vorgängermodelle?

Die Hauptvorteile von GPT-4o gegenüber den Vorgängermodellen sind seine erweiterten multimodalen Fähigkeiten, die Echtzeitgespräche und erweiterte Bild-/Audioverarbeitung mit geringeren Latenzen ermöglichen.

Kann GPT-4o mir beim Übersetzen von Sprachen helfen?

Ja. GPT-4o verfügt über bessere Mehrsprachenfunktionen und kann als guter Übersetzer für über 50 Sprachen dienen.

Was ist der Wissensstichtag für GPT-4o?

Der Wissensstichtag bzw. die neuesten Informationen, mit denen GPT-4o trainiert wurde, ist Oktober 2023.

Hat GPT-4o irgendwelche Einschränkungen?

Trotz seiner Fähigkeiten weist GPT-4o immer noch Einschränkungen auf, die von großen Sprachmodellen geerbt wurden, wie etwa potenzielle Voreingenommenheiten, Halluzinationen und das Fehlen eines robusten Langzeitgedächtnisses. Sein Wissen ist außerdem grundsätzlich auf seine Trainingsdaten beschränkt.