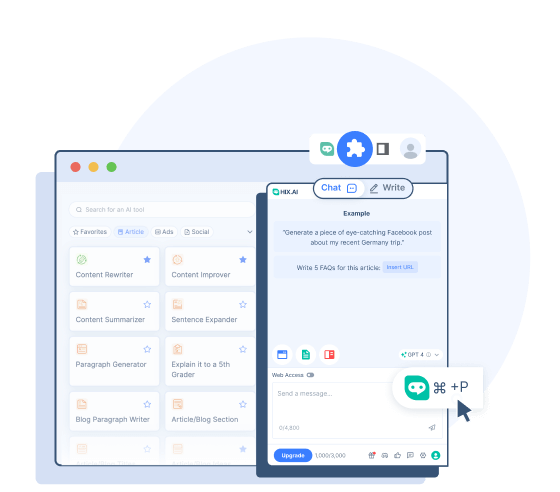

HIX Writer

Accédez à plus de 120 outils d’écriture d’IA pour améliorer votre expérience d’écriture.

Vérifier l'écrivain HIX

BrowserGPT

Découvrez l'assistant ChatGPT tout-en-un le plus puissant pour le Web.

Vérifiez le BrowserGPT

Tapez // pour bénéficier de notre assistance IA lorsque vous écrivez sur Google Docs.

Tapez // créez des e-mails convaincants et des réponses personnalisées.

Découvrez une alternative plus puissante à la barre latérale Bing pour Chrome.

Trouvez les réponses complètes de HIX.AI parmi les résultats de recherche typiques.

Sélectionnez n'importe quel texte en ligne à traduire, réécrire, résumer, etc.

Tapez // pour rédiger des messages Twitter concis mais puissants sur cette tendance.

Tapez // pour créer des légendes attrayantes pour vos publications Instagram.

Tapez // pour rédiger des publications Facebook interactives qui engagent votre communauté.

Tapez // pour fournir des réponses précieuses et votées positivement sur Quora.

Tapez // pour créer des publications Reddit qui trouvent un écho auprès de communautés spécifiques.

Résumez de longues vidéos YouTube en un seul clic.

- HIX Chat (Alternative ChatGPT)

Un chatbot IA de premier plan capable de répondre avec des informations à jour.

- HIX Chat (Pas de connexion)

Bénéficiez d’un accès illimité à HIX Chat. Aucune connexion n'est nécessaire.

- GPT-4o (pas de connexion)

Essayez la puissance avancée du GPT-4o avec moins de restrictions et une connexion plus fluide.

- ChatGPT (Pas de connexion)

Utilisez ChatGPT gratuitement sans vous connecter !

- Chat GPT-4 en ligne

Utilisez le chatbot GPT-4 gratuitement en ligne.

- Solveur mathématique IA

Obtenez des solutions étape par étape à tout problème de devoirs de mathématiques.

GPT-4o

- Histoire

GPT-4o : la prochaine évolution des modèles de langage d'OpenAI

GPT-4o (le « o » signifie « omni ») est un modèle de langage étendu multimodal de pointe développé par OpenAI et publié le 13 mai 2024. Il s'appuie sur le succès de la famille de modèles GPT et introduit plusieurs avancées dans la compréhension globale et la génération de contenu selon différentes modalités.

GPT-4o offre de meilleures capacités de traitement du langage naturel et un temps de réponse plus rapide par rapport aux modèles précédents. Il peut comprendre et générer de manière native du texte, des images et du son, permettant ainsi des expériences utilisateur plus intuitives et interactives. Cela permet à GPT-4o d'avoir des capacités améliorées non seulement pour répondre à des questions basées sur les connaissances et créer du texte, mais également pour analyser et décrire des images et des vidéos.

Capacités du GPT-4o

Les nouvelles améliorations apportées par OpenAI à ce modèle élèvent ses capacités audio, visuelle et textuelle.

Entrée et sortie multimodales

Chaque entrée et sortie de GPT4-o peut être n'importe quelle combinaison de texte, d'audio et d'images. Contrairement aux modèles précédents d'OpenAI, tous les textes, audios et images sont traités sans aucune conversion (GPT-4o peut lire les images, entendre l'audio et les sortir directement). Cela offre à GPT-4o la possibilité de les traiter plus rapidement et de mieux comprendre ces éléments.

Conversations naturelles en temps réel

Les capacités améliorées de reconnaissance vocale et de réponse du GPT-4o lui permettent d'engager des conversations verbales (même dans différentes langues) sans retards notables. Le modèle peut observer les tons et les émotions des locuteurs et fournir des réponses appropriées. Il peut également parler avec une voix naturelle et avec des nuances émotionnelles, permettant ainsi des communications plus sensibles.

Analyse et édition de contenu visuel

GPT-4o peut mieux comprendre et modifier le contenu visuel. Il peut lire les graphiques, le texte ou les données des images et en comprendre la signification. Vous pouvez télécharger des images pour analyse, obtenant ainsi des informations et des explications plus précises. Le modèle peut également créer ou modifier des images aussi exactement que vos demandes rapides avec une haute qualité.

Mémoire et conscience contextuelle

La fenêtre contextuelle améliorée de GPT-4 garantit qu'elle peut maintenir le contexte sur des conversations plus longues. Il prend en charge jusqu'à 128 000 jetons, permettant une analyse détaillée et des conversations cohérentes.

GPT-4o contre GPT-4 contre GPT-3.5

Vous souhaitez savoir en quoi GPT-4o est différent de GPT-4 et GPT-3.5 ? Voici leurs principales différences :

GPT-4o

- GPT-4o a été initialement publié en mai 2024.

- Il s'agit d'un modèle multimodal plus avancé avec des vitesses plus rapides et des latences plus faibles pour répondre aux entrées audio et vidéo.

- GPT-4o est formé sur des données jusqu'en octobre 2023.

- GPT-4o obtient de meilleurs résultats sur les tests de raisonnement, de reconnaissance vocale et de capacités visuelles.

- Il présente une amélioration significative du traitement de texte dans les langues non anglaises.

GPT-4

- GPT-4 a été initialement publié en mars 2023.

- Il s'agit d'un modèle multimodal, ce qui signifie qu'il peut comprendre les entrées d'images et de voix ainsi que les invites textuelles.

- GPT-4 est formé sur des données plus à jour, jusqu'en décembre 2023.

- GPT-4 fonctionne mieux que GPT-3.5 dans des domaines tels que le codage, l'écriture, le raisonnement et l'évitement des contenus non autorisés.

- GPT-4 est plus fiable et créatif, et obtient de meilleurs scores aux tests de référence que GPT-3.5.

GPT-3.5

- GPT-3.5 est sorti en novembre 2022. Il alimente la version gratuite de ChatGPT.

- GPT-3.5 est limité à la saisie et à la sortie de texte.

- Il est formé sur des données plus anciennes jusqu'en septembre 2021.

- GPT-3.5 peut parfois être moins fiable et moins créatif lors de la génération de réponses.

Comment accéder à GPT-4o

GPT-4o est rendu accessible depuis sa sortie. Il existe plusieurs façons d’accéder à sa puissance et d’en faire l’expérience :

Utilisez GPT-4o sur ChatGPT

OpenAI a permis aux utilisateurs de ChatGPT d'utiliser ce nouveau modèle directement sur le chatbot. Les utilisateurs gratuits auront accès avec restriction de message et ne pourront interagir avec ce modèle qu'avec du texte. Pour les utilisateurs payants de ChatGPT Plus, toutes ces restrictions sont levées.

Utilisez GPT-4o avec l'API d'OpenAI

OpenAI a également rendu GPT-4o disponible comme option modèle pour l'accès à l'API. Les développeurs sont désormais autorisés à intégrer la puissance GPT-4o dans leur projet ou application.

Utilisez GPT-4o sur HIX.AI

Si vous avez besoin d'un moyen plus pratique d'accéder à GPT-4o, vous pouvez l'essayer sur HIX.AI. C'est gratuit d'essayer sans avoir à vous connecter. Si vous ne pouvez pas accéder à GPT-4o via les méthodes officielles, il s'agit d'un autre moyen fiable d'utiliser ce modèle innovant.

Pourquoi utiliser GPT-4o sur HIX.AI

Accéder à GPT-4o sur HIX.AI présente plusieurs avantages :

Aucune connexion requise

Découvrez la commodité d’un accès instantané avec HIX.AI. Accédez simplement à notre page GPT-4o et vous pourrez immédiatement commencer à interagir avec GPT-4o.

Connexion plus fluide

Lorsque vous accédez à GPT-4o sur HIX.AI, vous êtes moins susceptible de rencontrer des problèmes de serveur. Nous nous efforçons de minimiser la latence et de maintenir des performances élevées pour votre connexion à ce modèle.

Accès illimité

Nous n'imposons aucune restriction sur l'accès à notre chatbot GPT-4o. Où et quand vous êtes, vous pouvez découvrir librement cette puissante innovation en matière d’IA.

Découvrez plus de ressources sur GPT-4 et ChatGPT

Apprenez-en davantage sur les modèles linguistiques les plus avancés grâce à nos articles informatifs ici :

Combien coûte Chat GPT 4 ?

Vous vous demandez combien coûte Chat GPT 4 ? Lisez ce guide pour en savoir plus sur le prix ChatGPT 4 et les alternatives que vous pourriez explorer.

10 meilleures applications ChatGPT

Découvrez les 10 meilleures applications ChatGPT pour vos appareils mobiles. Améliorez votre expérience d'IA avec les meilleures applications disponibles.

ChatGPT n'est pas disponible dans votre pays ?

ChatGPT n'est pas disponible dans votre pays ? N'ayez crainte, nous proposons une gamme de solutions de contournement ChatGPT indisponibles que vous pouvez essayer.

Qu'est-ce que ChatGPT ?

ChatGPT est un outil d'IA qui a pris d'assaut le monde. Mais qu'est-ce que ChatGPT ? Découvrez comment fonctionne ChatGPT ici.

Comment accéder ChatGPT sans connexion

Vous vous demandez comment accéder ChatGPT sans connexion ? Cherchez pas plus loin. Voici des façons d'utiliser le chatbot sans compte ChatGPT ni inscription.

Que signifie GPT dans ChatGPT ?

Que signifie GPT dans ChatGPT ? Cet article vous donnera la réponse et dévoilera d’autres mystères entourant l’acronyme GPT.

FAQ

Comment le GPT-4o surpasse-t-il les modèles précédents ?

Les principaux avantages du GPT-4o par rapport aux modèles précédents résident dans ses capacités multimodales améliorées, qui lui permettent d'effectuer des conversations en temps réel et une gestion avancée de la vision et de l'audio avec des latences plus faibles.

GPT-4o peut-il m'aider à traduire des langues ?

Oui. GPT-4o est doté de meilleures capacités multilingues et peut servir de bon traducteur pour plus de 50 langues.

Quelle est la date limite de connaissance pour GPT-4o ?

La date limite des connaissances, ou les dernières informations sur lesquelles GPT-4o a été formé, est octobre 2023.

GPT-4o a-t-il des limites ?

Malgré ses capacités, GPT-4o présente toujours des limites héritées des grands modèles de langage, telles que des biais potentiels, des hallucinations et un manque de mémoire à long terme robuste. Ses connaissances se limitent également fondamentalement à ses données d’entraînement.