Skriv // for å nyte AI-hjelpen vår mens du skriver på Google Dokumenter.

Skriv // lager overbevisende e-poster og personlig tilpassede svar.

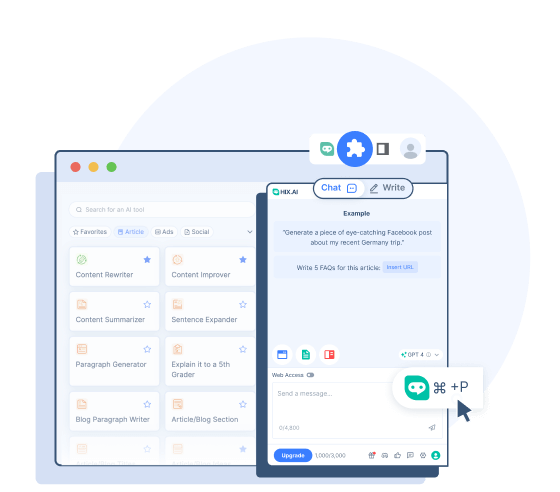

Utforsk et kraftigere Bing-sidefeltalternativ for Chrome.

Finn HIX.AIs omfattende svar blant typiske søkeresultater.

Velg hvilken som helst tekst på nettet for å oversette, omskrive, oppsummere osv.

Skriv // for å komponere konsise, men kraftige Twitter-innlegg den trenden.

Skriv // for å lage engasjerende bildetekster for Instagram-innleggene dine.

Skriv // for å lage utkast til interaktive Facebook-innlegg som engasjerer fellesskapet ditt.

Skriv // for å gi verdifulle, oppstemte svar på Quora.

Skriv // for å lage Reddit-innlegg som gir gjenklang med bestemte fellesskap.

Oppsummer lange YouTube-videoer med ett klikk.

- HIX Chat (ChatGPT Alternativ)

En ledende AI chatbot som kan svare med oppdatert informasjon.

- HIX Chat (Ingen pålogging)

Opplev ubegrenset tilgang til HIX Chat. Ingen pålogging er nødvendig.

- GPT-4o (ingen pålogging)

Prøv den avanserte kraften til GPT-4o med mindre begrensninger og jevnere tilkobling.

- ChatGPT (ingen pålogging)

Bruk ChatGPT gratis uten å logge på!

- GPT-4 Chat online

Bruk GPT-4 chatbot gratis online.

- Math AI Solver

Få trinnvise løsninger på alle matematiske lekser.

GPT-4o

- Historie

GPT-4o: Den neste utviklingen av OpenAIs språkmodeller

GPT-4o ("o" betyr "omni") er en toppmoderne multimodal storspråkmodell utviklet av OpenAI og utgitt 13. mai 2024. Den bygger på suksessen til GPT-modellfamilien og introduserer flere fremskritt i å forstå og generere innhold på tvers av ulike modaliteter.

GPT-4o tilbyr bedre naturlig språkbehandling og en raskere responstid sammenlignet med tidligere modeller. Den kan naturlig forstå og generere tekst, bilder og lyd, noe som muliggjør mer intuitive og interaktive brukeropplevelser. Dette gjør at GPT-4o har forbedrede evner til ikke bare å svare på kunnskapsbaserte spørsmål og lage tekst, men også analysere og beskrive bilder og videoer.

GPT-4o sine evner

De nye forbedringene som OpenAI bringer til denne modellen hever lyd-, syn- og tekstmulighetene.

Multimodal inngang og utgang

Hver inngang og utgang av GPT4-o kan være en hvilken som helst kombinasjon av tekst, lyd og bilder. I motsetning til OpenAIs tidligere modeller, behandles all tekst, lyd og bilder uten noen konvertering (GPT-4o kan lese bilder, høre lyd og sende dem direkte). Dette gir GPT-4o muligheten til å behandle dem raskere og ha bedre forståelse av disse elementene.

Naturlige samtaler i sanntid

De forbedrede stemmegjenkjennings- og responsmulighetene til GPT-4o gjør at den kan delta i verbale samtaler (selv på forskjellige språk) uten merkbare forsinkelser. Modellen kan observere toner og følelser hos høyttalerne og levere riktig respons. Den kan også snakke med en naturlig stemme og med følelsesmessige nyanser, noe som muliggjør mer sensitiv kommunikasjon.

Visuell innholdsanalyse og redigering

GPT-4o kan bedre forstå og redigere visuelt innhold. Den kan lese grafikk, tekst eller data på bilder og forstå betydningen bak. Du kan laste opp bilder for analyse, og få mer presis innsikt og forklaringer. Modellen kan også lage eller redigere bilder så nøyaktig som dine spørsmål med høy kvalitet.

Minne og kontekstuell bevissthet

GPT-4s oppgraderte kontekstvindu sikrer at den kan opprettholde kontekst over lengre samtaler. Den støtter opptil 128 000 tokens, noe som muliggjør detaljert analyse og sammenhengende samtaler.

GPT-4o vs GPT-4 vs GPT-3.5

Vil du vite hvordan GPT-4o er forskjellig fra GPT-4 og GPT-3.5? Her er deres viktigste forskjeller:

GPT-4o

- GPT-4o ble opprinnelig utgitt i mai 2024.

- Det er en mer avansert multimodal modell med raskere hastigheter og lavere ventetider for å svare på lyd- og videoinnganger.

- GPT-4o er trent på data frem til oktober 2023.

- GPT-4o presterer bedre på benchmarks for resonnement, talegjenkjenning og visuelle evner.

- Den har betydelig forbedring i tekstbehandling på ikke-engelske språk.

GPT-4

- GPT-4 ble opprinnelig utgitt i mars 2023.

- Det er en multimodal modell, noe som betyr at den kan forstå bilde- og stemmeinndata sammen med tekstmeldinger.

- GPT-4 er opplært på mer oppdaterte data, frem til desember 2023.

- GPT-4 yter bedre enn GPT-3.5 på områder som koding, skriving, resonnement og unngåelse av innhold som ikke er tillatt.

- GPT-4 er mer pålitelig og kreativ, og har bedre score på benchmarks enn GPT-3.5.

GPT-3.5

- GPT-3.5 ble utgitt i november 2022. Den driver gratisversjonen av ChatGPT.

- GPT-3.5 er begrenset til tekstinntasting og -utgang.

- Den er trent på eldre data frem til september 2021.

- GPT-3.5 kan noen ganger være mindre pålitelig og kreativ når den genererer svar.

Slik får du tilgang til GPT-4o

GPT-4o har blitt gjort tilgjengelig siden utgivelsen. Det er flere måter du kan få tilgang til og oppleve kraften på:

Bruk GPT-4o på ChatGPT

OpenAI har tillatt ChatGPT-brukere å bruke denne nye modellen rett på chatboten. Gratis brukere vil ha tilgang med meldingsbegrensning og kan bare samhandle med denne modellen med tekst. For betalte ChatGPT Plus-brukere er alle disse begrensningene opphevet.

Bruk GPT-4o med OpenAIs API

OpenAI har også gjort GPT-4o tilgjengelig som et modellalternativ for API-tilgang. Utviklere har nå lov til å integrere GPT-4o-kraften i prosjektet eller applikasjonen deres.

Bruk GPT-4o på HIX.AI

Hvis du trenger en mer praktisk måte å få tilgang til GPT-4o på, kan du prøve den på HIX.AI. Det er gratis å prøve uten å måtte logge inn. Hvis du er begrenset fra å få tilgang til GPT-4o gjennom de offisielle metodene, er dette en annen pålitelig måte å bruke denne innovative modellen på.

Hvorfor bruke GPT-4o på HIX.AI

Å få tilgang til GPT-4o på HIX.AI kommer med flere fordeler:

Ingen pålogging kreves

Opplev bekvemmeligheten med umiddelbar tilgang med HIX.AI. Bare naviger til GPT-4o-siden vår, så kan du begynne å samhandle med GPT-4o med en gang.

Mykere tilkobling

Når du får tilgang til GPT-4o på HIX.AI, er det mindre sannsynlig at du opplever serverproblemer. Vi streber etter å minimere ventetiden og opprettholde høy ytelse for din tilkobling til denne modellen.

Ubegrenset tilgang

Vi pålegger ingen begrensninger på vår GPT-4o chatbot-tilgang. Uansett hvor og når du er, kan du oppleve denne kraftige AI-innovasjonen fritt.

Oppdag flere ressurser om GPT-4 og ChatGPT

Lær mer om de mest avanserte språkmodellene med våre informative artikler her:

Beste PromptBase-alternativer

Hvorfor betale for PromptBase når denne listen over gratis PromptBase-alternativer tilbyr et mangfoldig utvalg av spørsmål for både grafisk og skrevet AI-generert innhold? Klikk på denne siden for å lære mer.

Hva er ChatGPT ?

ChatGPT er et AI-verktøy som har tatt verden med storm. Men hva er ChatGPT ? Finn ut hvordan ChatGPT fungerer her.

GPT-4 parametere forklart

Har du spørsmål om GPT-4 antall parametere? I så fall, la oss se på hvor mange parametere som er i GPT-4 og hva disse GPT-4 parametrene gjør.

Oppdager Turnitin ChatGPT ?

Kan ChatGPT oppdages av Turnitin ? Programvarens nye AI-genererte innholdsdetektorfunksjon møter AI-skriveverktøy. Klikk på denne siden for å lære mer om hvordan Turnitin håndterer innhold laget av ChatGPT .

GPT-3 vs. GPT-4 : Hva er forskjellene?

Undersøker GPT-4 vs. GPT-3 parametere og muligheter: Hvilken modell er overlegen, og hva kan vi forvente av fremtiden til GPT?

Hvordan skrive et blogginnlegg med ChatGPT

Planlegger du å skrive et blogginnlegg? I denne artikkelen forklarer vi hvordan du skriver en blogg gratis med ChatGPT og introduserer andre effektive måter å skrive blogginnlegg på.

Vanlige spørsmål

Hvordan overgår GPT-4o de tidligere modellene?

De største fordelene med GPT-4o i forhold til de tidligere modellene er dens forbedrede multimodale evner, som gjør det mulig for den å utføre samtaler i sanntid og avansert syn/lydhåndtering med lavere ventetider.

Kan GPT-4o hjelpe meg med å oversette språk?

Ja. GPT-4o kommer med bedre flerspråklige muligheter og kan fungere som en god oversetter for 50+ språk.

Hva er fristen for kunnskap for GPT-4o?

Kunnskapsskjæringsdatoen, eller den siste informasjonen GPT-4o ble trent på, er oktober 2023.

Har GPT-4o noen begrensninger?

Til tross for sine evner, har GPT-4o fortsatt begrensninger som er arvet fra store språkmodeller som potensielle skjevheter, hallusinasjoner og mangel på robust langtidsminne. Kunnskapen er også grunnleggende begrenset til treningsdataene.